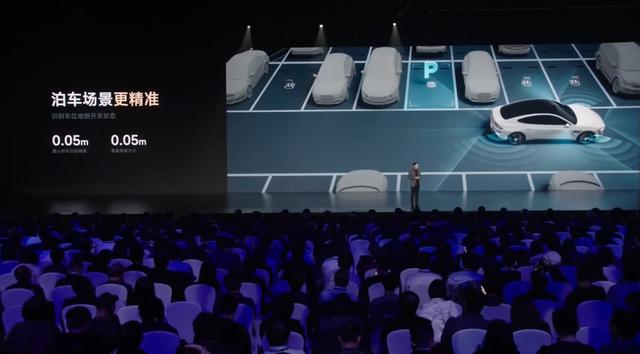

从泊车场景来看,建模像素网格大小仅在0.05m,这也是上面超分辨率占用网络实现的最高精度。该模式下,小米会通过超分辨率技术加强视觉感应,从而实现0.05m的精度。但相应的代价就是该模式下感知范围是最小的,很明显小米在将Orin-X的计算力分配偏向于提高精度方面。

而城区与高速场景精度则维持在0.2m,不同之处在于城区左右识别范围达到了160m,而高速场景着重于加强前方侦测距离,达到250m。但有一个逻辑冲突,就是小米前向激光雷达最远检测距离为200m,车辆前方250m明显超过了激光雷达的检测范围。

而根据小米SU7的感知硬件分布,前向激光雷达之外也拥有一套双目高清摄像头组作为辅助,我们有理由联想小米在该模式下借助超分辨率技术放大前方细节,在雷达侦测范围之外用“看”来预测前方路况。而小米在发布会PPT上也明确写道“可实现前方150m突发事故减速变道”,这意味着小米智驾系统在决策层依旧使用了雷达点云的定位验证,在200m范围内进行精细感知、150m范围内开始决策。

不过让人很好奇的是,小米是如何判断车辆所处环境为哪种类型?大概率小米会使用一套场景认证机制,让现实场景与AI模型库进行对撞,来判定车辆所处场景。如检测到停车杆或停车线则判定为泊车场景,或系统判定道路情况确定城区或高速场景。小米如果能够实现这三个场景的识别与无缝衔接,这才是真正的“黑科技”。写在最后

从技术角度来看,小米这次智能驾驶的更新主轴在于提升精度,用高精度的占用网络和BEV鸟瞰图实现驾驶体验的更新。但很明显即使是500TOPS以上的双Orin-X芯片也无法同时进行超分辨率图像处理与毫秒级的智能驾驶决策判断,因此小米会使用变焦BEV调配系统算力调用,在重感知的泊车场景中提升精度、在城市/高速NOA场景中释放一部分算力保证决策。